Les questions essentielles à vous poser pour bien évaluer l'acquisition d'une compétence

Vous cherchez à former vos nouveaux collaborateurs à la relation client. Vous connaissez le refrain : les apprenants suivront une journée de formation, peut-être un e-learning... et après ? Comment vous assurer qu'il restera quelque chose de leur apprentissage cette fois-ci ? Vous pensez naturellement à une formation certifiante : oui, mais pour quel critère de certification ? Comment vérifier l'acquisition réelle des compétences visées ?

On pourrait penser que l'enjeu se résume à la conception d'un test ou examen final qui permettrait de cocher les cases de ce qui a été vu lors de la formation. En vérité, l'enjeu est plus large et implique de se poser 3 grandes questions : Que tester ? Comment tester ? Combien de fois tester ?

1. Quelle compétence tester : un objectif précis est un objectif évaluable

Admettons que vous vouliez que vos collaborateurs suivent une formation en ligne diplômante sur une soft skill comme « la culture digitale ». Si on vous donne pour mission d’imaginer un examen final pour la délivrance du diplôme, vous ne saurez probablement pas par où commencer. C’est normal ! Avec un objectif flou comme celui-ci, vous serez bien en peine de concevoir une évaluation pertinente.

L’essentiel du travail doit être fait en amont, dans la définition des objectifs pédagogiques. Plus vos objectifs sont finement découpés ; plus ils reflètent un changement d’état clair, plus il vous sera facile de les tester (c’est l’objet de notre article sur l'optimisation des objectifs de formation). Ainsi, vous pourriez décomposer votre parcours sur la culture digitale en micro-compétences associées à une progression bien identifiée : pour chaque compétence, contraster l'état final de l'apprenant avec son état initial.

Prenons l’exemple de la compétence « gérer son identité numérique ». Quelqu’un qui maîtrise cette compétence saura gérer ses paramètres de confidentialité en ligne, éviter les publications qui pourraient lui porter préjudice, ou encore réagir face à un commentaire négatif. Une fois que vous en êtes arrivés là, l’exercice pour tester la compétence s’écrit presque tout seul ! En identifiant bien vos objectifs pédagogiques, vous faites donc plus de la moitié du travail nécessaire pour une évaluation réussie d'une acquisition de compétence.

2. Comment tester : au plus près des conditions réelles

Encore faut-il concevoir des épreuves qui répondent fidèlement à vos objectifs. Une erreur courante en la matière est d'attendre que des apprenants qui ont été évalués principalement sur la théorie sortent pleinement opérationnels d'une formation. Pourtant, on ne donne pas le permis à tous ceux qui réussissent le code de la route : on attend de voir ce qu'ils font avec le volant entre les mains ! C'est la même chose pour n'importe quelle formation. Former des employés de banque à une nouvelle règlementation sur le blanchiment d'argent, ce n'est pas simplement les évaluer sur la connaissance des nouvelles procédures à suivre, c'est aussi les mettre en face de dossiers clients qu'ils devront accepter ou non dans le cadre de ces procédures.

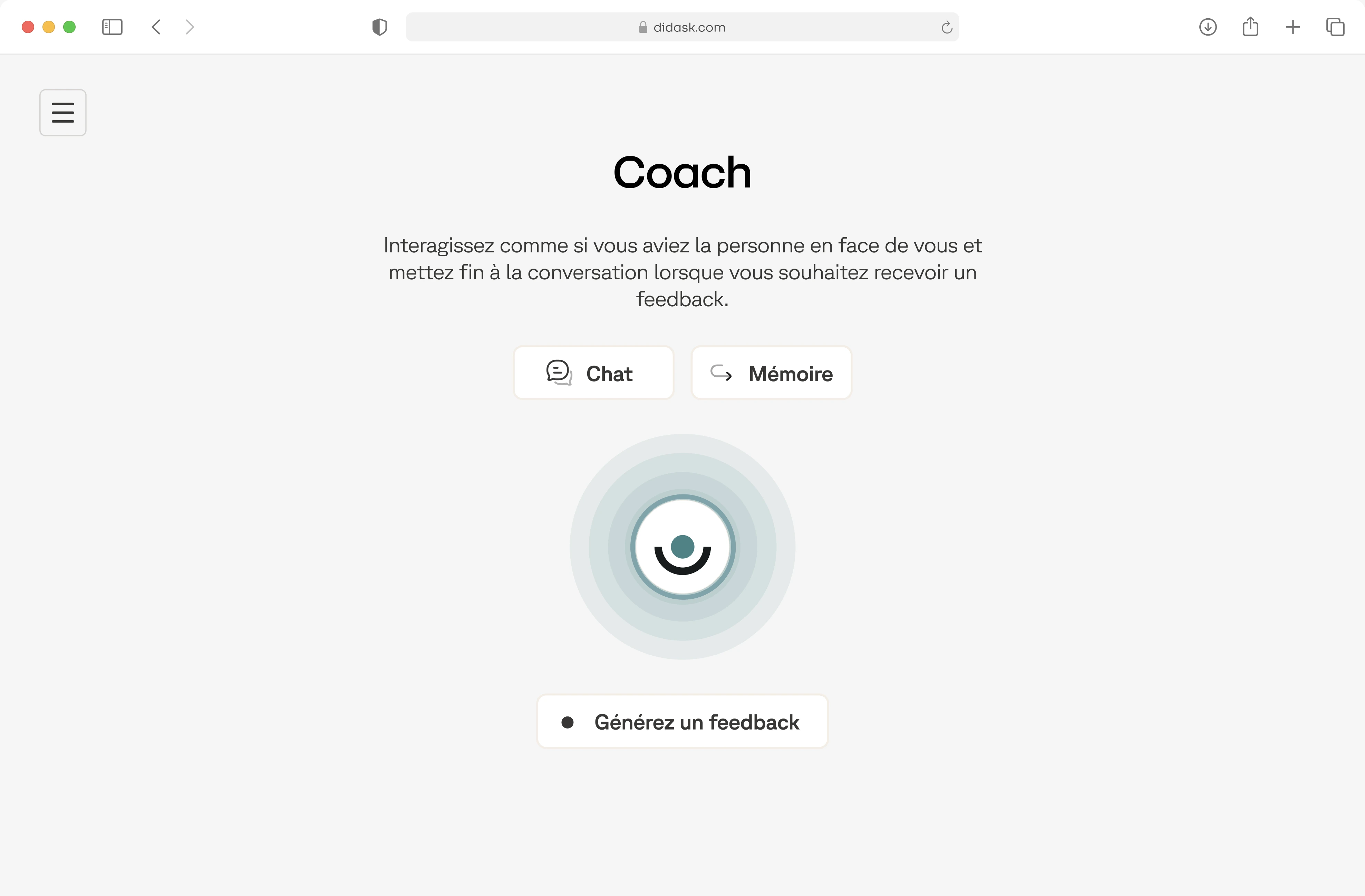

Dans la même logique, les tests d'évaluation doivent proposer une difficulté comparable à celle que les apprenants rencontreront en situation réelle (voir notre article sur les difficultés désirables). L'astronaute se teste en apesanteur et non dans l'atmosphère : pourquoi en serait-il différemment de vos apprenants ? Prenons le cas d'un training sur la sécurité. Vos stagiaires vont partir en mission près d'une frontière dangereuse. Pour les évaluer, vous pouvez les interroger à l'oral : « Vous arrivez à un checkpoint, un milicien vous demande d'ouvrir le coffre de votre véhicule pour vérifier que vous ne transportez rien d'illégal. Que faites-vous ? ». Les apprenants peuvent répondre correctement dans le confort d'une salle chauffée, mais êtes-vous sûr qu'ils réagiront de la bonne façon la peur au ventre face à un homme lourdement armé ? Une simulation serait donc ici préférable pour capturer cette difficulté supplémentaire qu'est la peur. Bien sûr, une simulation parfaite est rarement possible, mais il faut dans tous les cas se demander ce qui s'approcherait le mieux d'une mise en situation réelle compte tenu de vos moyens. La méthode d'identification des "erreurs pertinentes" que nous avons intégré dans notre solution chez Didask est un bon moyen d'y parvenir.

Ce qu'il faut retenir ici, c'est que le changement que vous souhaitez pour votre apprenant est un changement dans le travail, à l'école, au quotidien : il ne s'arrête pas à 18h le jour de la formation. Il faut soigneusement éviter tout ce qui, dans votre évaluation, pourrait créer une bulle séparant l'apprentissage de la « vraie vie ».

3. Quand tester : vers l’évaluation tout au long de la vie

C'est précisément pour cette raison qu'il faut remplacer la question de l'évaluation, au singulier, par celle des évaluations, au pluriel. L'examen final doit laisser place à l'évaluation tout au long de la vie, en toute sérénité.

La plupart du temps, un cours ou une formation se construit de la manière suivante : une ou plusieurs sessions de transmission de connaissances, puis un examen final (sorte de jugement dernier qui permettrait de séparer les bons des mauvais) à l'issue duquel les apprenants sont lâchés dans la nature. Ce modèle, hérité en partie de l'école, pourrait être amélioré de deux façons.

D'abord en prenant l'habitude de tester régulièrement les apprenants avant l'examen. Si vous voulez former au langage informatique HTML/CSS, plutôt que de tout miser sur un unique projet final à l'issue de la formation (créez une page web complète), pourquoi ne pas proposer des micro-projets à réaliser à chaque étape de la formation (créez un menu, créez un tableau...) ?

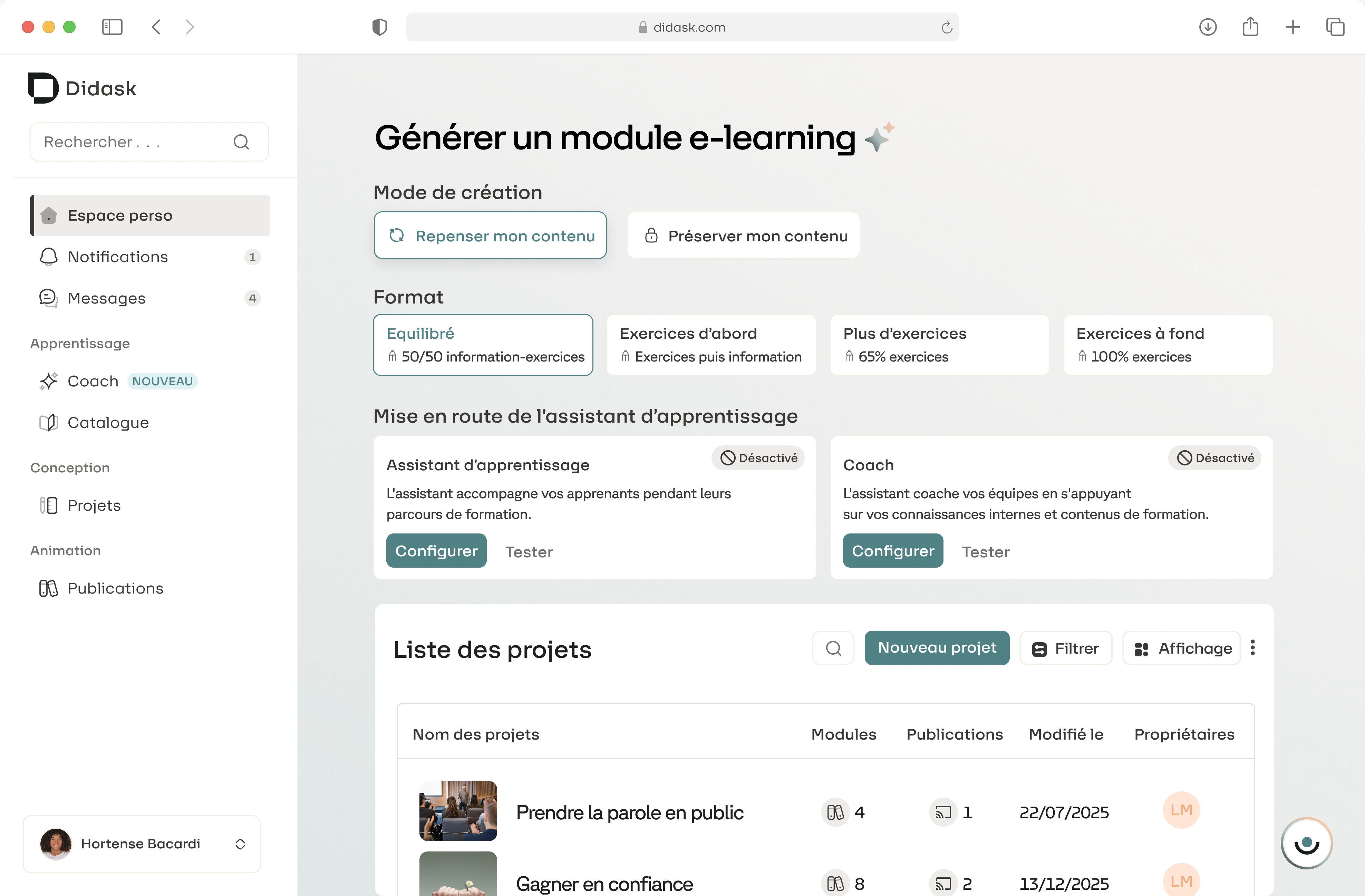

Ensuite, en les incitant à continuer à se tester eux-mêmes après l'examen : vous pourriez ainsi inciter vos apprenants à se lancer ponctuellement des petits défis liés à leur apprentissage pour vérifier qu'ils continuent à progresser au quotidien. Ainsi, dans le cadre d'une formation sur la qualité de vie au travail, vos apprenants pourraient prendre l'engagement de créer un planning journalier prévoyant de véritables plages de respiration, puis vérifier dans quelle mesure ils ont bien respecté ce planning. Dans la solution e-Learning Didask, nous avons à cet effet intégré des micros-défis, qui sont proposés aux apprenants à l'issue des modules.

Cette (auto)évaluation constante produit 3 effets positifs :

- Premièrement, elle permet d'avoir un retour d'information correctif : si vous n'avez pas compris la première leçon sur les lois du mouvement de Newton, mieux vaut le savoir tout de suite que le découvrir au moment de l'examen, lorsque vous devrez prédire une série de trajectoires complexes (voir nos articles sur l'illusion de maîtrise et sur le testing effect).

- Deuxièmement, la multiplicité des évaluations permet de diversifier les contextes d'apprentissage. La compétence de prise de parole en public, par exemple, ne s'exerce pas de la même manière selon que l'on s'adresse à un petit groupe ou à un grand groupe, ou que l'on parle avec ou sans notes.

- Troisièmement, évaluer plus souvent permet de dédramatiser le rapport à l'erreur. (lire à ce sujet l'article sur l'apprentissage par essai-erreur : libérez le potentiel du feedback). Une fois banalisée, l'évaluation cesse d'être un jugement définitif sur la personne, pour devenir une estimation à l'instant t de votre progression dans un processus continu d'apprentissage.

Un objectif percutant, des exercices au plus proche du réel, une évaluation banalisée : autant d'éléments qui vous permettront de vous assurer que vos apprenants peuvent attester des compétences qu'ils ont acquises, non seulement par un diplôme ou une certification, mais aussi et surtout dans leur poste et dans leur vie de tous les jours.

.webp)

.png)