Récemment, une étude du MIT Media Lab a agité les réseaux sociaux. D’après les résumés viraux qui ont circulé, utiliser ChatGPT pendant l’apprentissage nous rendrait paresseux… et créerait une dette cognitive.

L’outil qui nous simplifie le quotidien serait-il en train de freiner nos capacités mentales ? Pas si vite.

L’étude soulève une vraie question : les LLM sont-ils des accélérateurs d’apprentissage ou des béquilles qui affaiblissent nos capacités cognitives ?

Mais en y regardant de plus près, ses résultats montrent surtout que lorsqu’une tâche est déléguée à un outil externe, les performances cognitives diminuent – ce qui n’est pas en soi une découverte nouvelle, ni une preuve d’un appauvrissement durable de nos capacités.

Et surtout, cela ne signifie pas que l’usage des LLM crée une "dette cognitive". Nous verrons même qu’ils peuvent, dans certains cas, renforcer l’apprentissage.

Pour bien comprendre ce que cette étude dit (et ne dit pas), encore faut-il examiner de près ce qu’elle teste réellement.

Zoom sur l’étude du MIT Media Lab

Dans cette étude, les chercheurs ont évalué l’impact de l’utilisation de ChatGPT sur l’engagement cognitif lors d’une tâche d’écriture. Pour cela, ils ont recruté 54 participants répartis en trois groupes : un groupe « sans outil », un groupe utilisant des moteurs de recherche classiques, et un groupe ayant accès à ChatGPT. Chaque participant s’est rendu trois fois au laboratoire pour rédiger un essai, à chaque fois sur un sujet choisi parmi trois propositions (par exemple : le bonheur, la loyauté, etc.).

Lors de chaque session, quatre variables ont été mesurées : l’activité cérébrale (via EEG), la qualité des textes produits, la mémoire déclarative (capacité à se souvenir de ce qui avait été écrit) et le sentiment de propriété intellectuelle vis-à-vis de l’essai.

Les résultats dessinent un pattern net : bien que les textes rédigés avec l’aide de ChatGPT soient généralement jugés de meilleure qualité, dans cette étude, les participants utilisant ce LLM présentent une activité cérébrale nettement réduite, une mémoire plus faible de leur production et un sentiment de propriété moindre comparé au groupe sans outil. En d’autres termes, l’outil semble induire un désengagement cognitif.

Pour approfondir, les auteurs ont mené une session complémentaire avec 18 des participants initiaux. Cette fois, les conditions étaient inversées : ceux ayant utilisé ChatGPT devaient rédiger sans aide, et inversement. Les résultats de cette session de « transfert » sont particulièrement éclairants. Les participants passant de ChatGPT à sans outil retrouvent un niveau d’activité cérébrale et de mémoire similaire à ceux n’ayant jamais utilisé l’IA. À l’inverse, ceux passant de sans outil à ChatGPT voient leur engagement cognitif chuter rapidement.

Ce point est crucial : l’effet observé n’est pas irréversible. L’usage de ChatGPT ne semble pas induire de dommages durables ou de « dette cognitive » empêchant un engagement futur, mais plutôt un état temporaire de moindre mobilisation cognitive, réversible dès que l’on reprend le contrôle de la tâche.

Cette nuance mérite d’être soulignée, d’autant que plusieurs réactions au papier ont exagéré ses implications en affirmant que ChatGPT « endommagerait notre cerveau ». Or, les données ne soutiennent pas cette thèse. Elles illustrent plutôt un phénomène intuitif : lorsqu’on délègue une tâche à un outil intelligent, on fournit naturellement moins d’effort cognitif. Ce n’est pas nouveau. Le même effet est observé lorsqu’on utilise un GPS pour s’orienter : certaines ressources cognitives sont moins sollicitées, et la mémorisation s’en ressent.

Cela dit, plusieurs limites doivent être prises en compte. Tout d’abord, l’étude est un préprint, c’est-à-dire qu’elle n’a pas encore été relue par des pairs, étape essentielle pour valider la robustesse méthodologique et l’interprétation des résultats. Ensuite, la taille des échantillons est relativement modeste (moins de 20 participants par groupe), ce qui est rarement idéal pour des mesures EEG, connues pour leur forte variabilité interindividuelle. Enfin, les résultats ne portent que sur une tâche spécifique : la rédaction d’un essai.

Alors, faut-il en conclure que l’utilisation des LLM comme ChatGPT nuit à l’apprentissage ? Pas nécessairement.

D’autres études montrent au contraire que les LLM peuvent favoriser l’apprentissage futur, notamment lorsqu’ils sont utilisés comme outils de feedback ou de clarification, et non comme substituts à la tâche elle-même.

Des LLM qui améliorent l’apprentissage

L’expérience menée par Lira et al. (2025) sur la rédaction de lettres de motivation apporte un éclairage complémentaire intéressant. Les chercheurs ont conduit deux expériences, avec répartition aléatoire des participants. Dans la première, ces derniers ont été assignés à un entraînement à la rédaction, avec ou sans assistance par IA. Tous ont ensuite passé un test de rédaction sans aide, le lendemain.

Contrairement aux prédictions majoritaires, les participants ayant pratiqué avec l’IA ont mieux réussi ce test final. Plus surprenant encore : ils avaient fourni moins d’effort lors de la phase d’entraînement — en témoignent le temps passé, le nombre de frappes au clavier, ainsi que leurs évaluations subjectives — tout en obtenant de meilleurs résultats.

La seconde expérience révèle un mécanisme particulièrement instructif : les participants qui se contentaient d’observer des exemples générés par IA (sans pouvoir les modifier) ont obtenu des résultats comparables à ceux ayant utilisé activement l’outil. Ce constat suggère que l’exposition à des productions de haute qualité peut générer un apprentissage implicite, en enrichissant les modèles mentaux des apprenants même sans interaction directe.

Autrement dit, l’IA ne se substitue pas toujours aux efforts mentaux ni à un apprentissage efficace. Dans certains contextes, elle peut même les renforcer. Ces résultats font écho à ceux de Bastani et al. (2024), qui montrent que l’impact de GPT dépend fortement des usages qu’on en fait, ainsi que des apports cognitifs et métacognitifs qu’il permet d’activer.

Dans cette étude menée auprès de près de 1 000 lycéens turcs en mathématiques, les chercheurs ont comparé l’impact de différentes modalités d’usage de GPT-4 sur l’apprentissage. Trois groupes ont été constitués : un groupe contrôle avec ressources classiques (manuel et notes), un groupe « GPT » avec interface standard de ChatGPT, et un groupe « GPT Tutor » avec version spécifiquement conçue selon des principes pédagogiques.

L’expérimentation a duré un semestre, avec des sessions de pratique assistée suivies d’évaluations finales sans assistance. Les chercheurs ont mesuré à la fois la progression immédiate et la performance finale.

Les résultats révèlent un contraste marquant : le groupe « GPT » a vu ses performances augmenter de 48 % pendant les sessions assistées, mais a affiché une baisse de 17 % lors des examens finaux par rapport au groupe contrôle. À l’inverse, le groupe « GPT Tutor » a non seulement amélioré ses performances de 127 % durant les entraînements, mais a maintenu un niveau équivalent au groupe contrôle lors des évaluations finales.

Cette différence s’explique par la conception radicalement différente du dispositif « GPT Tutor » : prompts pédagogiques de plus de 500 mots contextualisés, guidance par indices progressifs plutôt que fourniture directe de réponses, intégration aux objectifs pédagogiques fixés par les enseignants… Autant de garde-fous qui empêchent l’usage passif de l’IA comme simple « machine à réponses » et favorisent l’activation du raisonnement personnel.

L’approche Didask : quatre piliers pour éviter l’effet de béquille technologique

Face aux dérives identifiées par la recherche, Didask a développé une approche d’intégration de l’IA centrée sur l’apprentissage durable, plutôt que sur la performance immédiate. Cette stratégie repose sur quatre piliers conçus pour faire de l’IA un véritable catalyseur pédagogique.

1. Parcours adaptatifs : une personnalisation cognitive en profondeur

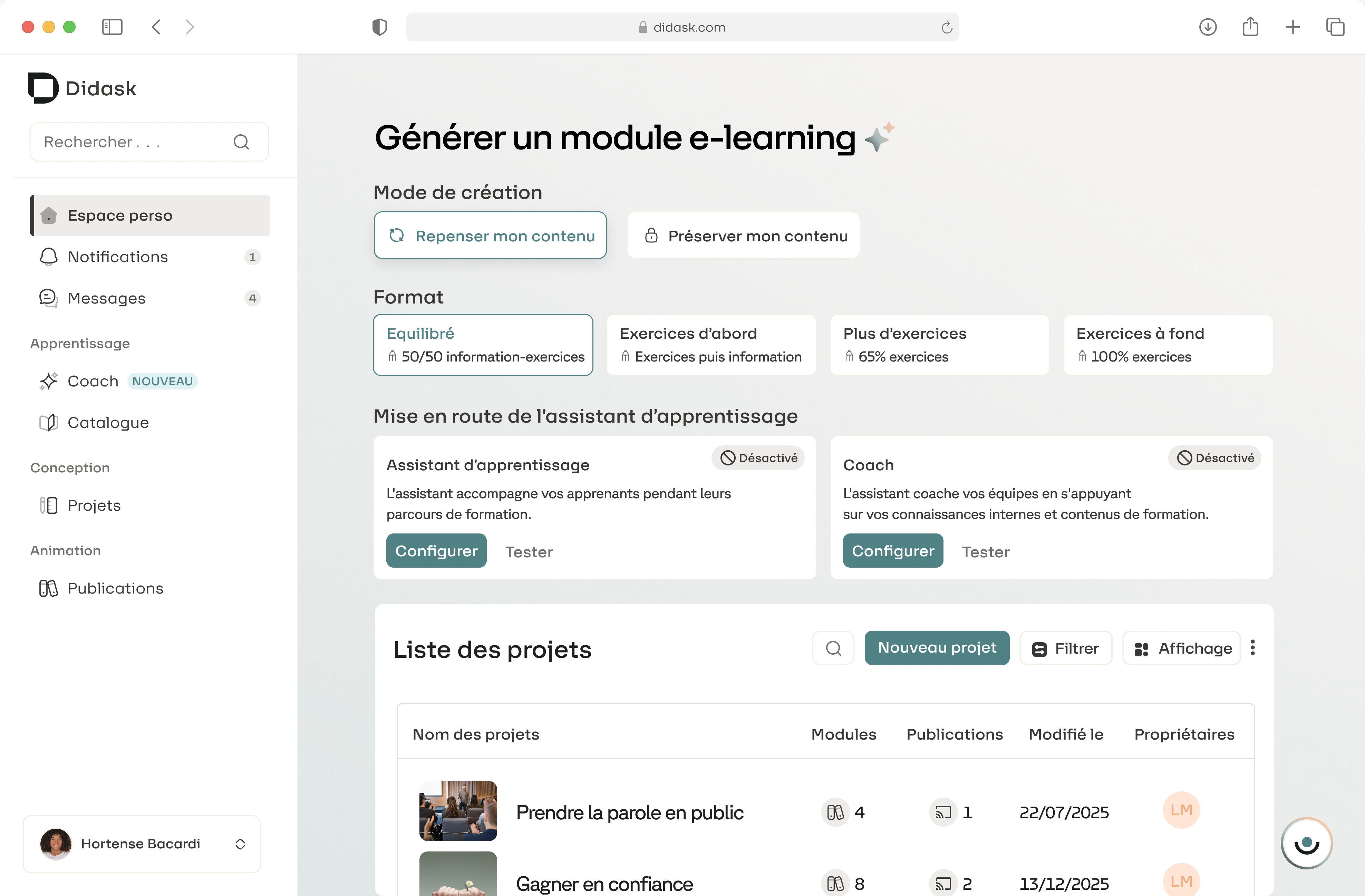

Chez Didask, l’adaptive learning ne se limite pas à adapter le contenu. Le système génère en moins de 5 minutes des tests de positionnement qui identifient les enjeux cognitifs propres à chaque apprenant.

Prenons l’exemple d’une formation commerciale en cinq modules : comprendre les produits, accrocher le client, dérouler le pitch, gérer les objections, conclure la vente. Claire, déjà familière des produits, validera rapidement le module A et se verra proposer directement le parcours B-C-D-E. Thomas, vendeur chevronné mais peu à l’aise avec la phase d’accroche, suivra un parcours A-C-D adapté à ses besoins spécifiques.

Cette granularité permet de réduire la surcharge cognitive tout en respectant les acquis. L’algorithme évite les interventions pédagogiques superflues pour concentrer l’effort là où il est réellement nécessaire. Une approche alignée avec les principes issus de la recherche : l’IA doit renforcer l’efficacité sans court-circuiter l’effort cognitif indispensable.

2. Feedbacks immédiats et contextualisés : apprendre par l’erreur, sans dépendance

L’IA Pédagogique Didask génère automatiquement, pour chaque réponse d’un apprenant, un feedback explicatif, bienveillant et contextualisé. Contrairement à des réponses toutes faites qui induisent une forme de dépendance — comme l’ont montré les travaux de Bastani — ces retours visent à expliciter le raisonnement, et à renforcer l’ancrage du message clé.

Les erreurs sont traitées comme autant d’opportunités d’apprentissage. Les exercices sont conçus pour faire émerger naturellement des erreurs fréquentes dans des dilemmes réalistes. Chaque option est sobre, plausible, et les feedbacks apportent une vraie valeur informationnelle. L’apprenant comprend ce qui est juste, pourquoi cela l’est, et comment éviter l’erreur à l’avenir.

Une logique directement en phase avec l’étude de Lira : l’exposition à des exemples de qualité, accompagnés d’explications structurantes, enrichit les schémas mentaux sans créer de dépendance.

3. Mises en situation ancrées dans le réel professionnel

L’une des spécificités fortes de Didask est sa capacité à générer des mises en situation authentiques, directement issues du quotidien professionnel des apprenants. L’IA Pédagogique crée en un clic des scénarios concrets, avec des choix plausibles qui reflètent les réalités du terrain.

Les formats sont variés : du simple « que feriez-vous ? » à des enchaînements plus complexes de catégorisation, procédures, ou simulations multiparamétriques. L’objectif : permettre à l’apprenant de prendre les bonnes décisions dans des contextes proches de ceux qu’il rencontrera sur le terrain.

Cette contextualisation permet d’éviter un écueil souvent pointé dans la recherche : la généralité des LLM, qui limite leur transférabilité. En ancrant chaque situation dans les spécificités métier, Didask maintient l’engagement et assure la pertinence pédagogique.

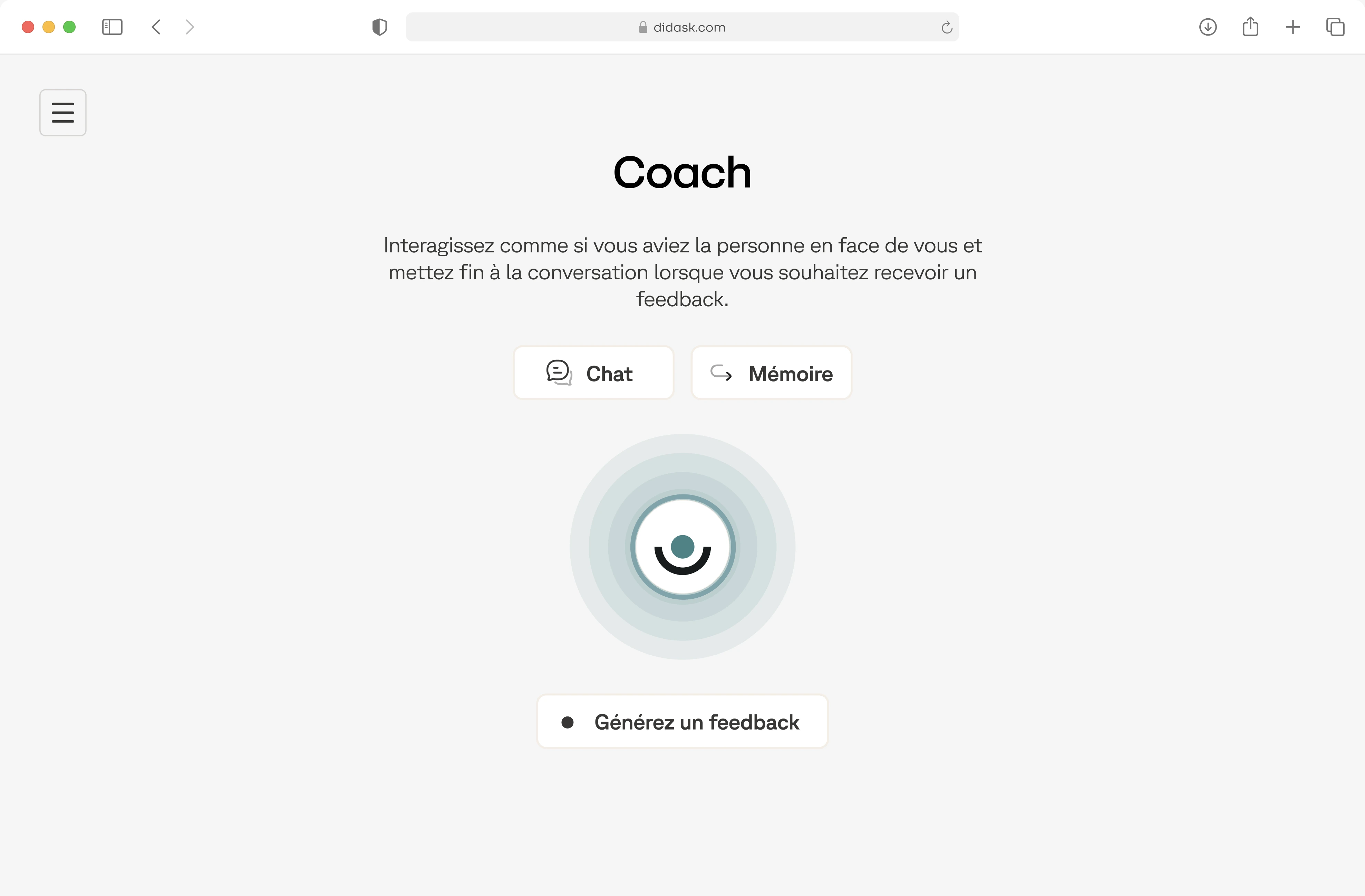

4. Didia : un assistant d’apprentissage omniprésent, avec des garde-fous

Didia incarne une nouvelle génération d’assistants pédagogiques : plus qu’un chatbot, il accompagne les collaborateurs dans leur apprentissage, formel comme informel.

Pendant la formation, Didia aide les apprenants à mieux comprendre les contenus : reformulations, exemples, liens entre concepts… comme le ferait un tuteur humain.

En dehors des modules, Didia répond aux questions métier du quotidien. Une manager confrontée à son premier conflit d’équipe peut décrire sa situation et obtenir un accompagnement contextualisé, basé sur la base de connaissances de l’entreprise. L’IA propose des cas pratiques ciblés et suggère des modules complémentaires pour approfondir.

Ce soutien permanent donne naissance à un véritable écosystème d’apprentissage continu, bien plus riche qu’un simple chatbot, et qui dépasse largement le cadre d’une formation ponctuelle. Didia intègre les garde-fous reconnus par la littérature scientifique comme essentiels : contextualisation fine, guidance progressive, progression structurée. Autant de leviers qui favorisent l’autonomie des apprenants, sans glisser vers une dépendance à l’outil.

Conclusion

L’intégration des LLM dans l’apprentissage n’est ni intrinsèquement bénéfique, ni foncièrement problématique. Les données empiriques montrent que leur impact dépend avant tout de la qualité de leur intégration pédagogique.

Entre le solutionnisme technophile et le rejet conservateur, une voie médiane s’impose : celle d’une augmentation cognitive raisonnée, où l’IA amplifie les capacités humaines sans s’y substituer.

Chez Didask, c’est cette trajectoire qui guide le développement de nos dispositifs : des environnements d’apprentissage où les LLM deviennent de véritables partenaires cognitifs, plutôt que des béquilles intellectuelles. Cela implique une conception intentionnelle des interactions, un accompagnement humain préservé, et une attention constante à l’équilibre entre efficacité immédiate et développement durable des compétences.

C’est à cette condition que l’IA pourra contribuer à une transformation éducative véritablement vertueuse.

.webp)

.png)