Très peu de technologies ont connu une percée aussi rapide et massive que les IA Génératives. Aujourd’hui, ChatGPT est utilisé par des centaines de millions de personnes. Cependant, la véritable révolution opère en arrière-plan. Répondre, résumer, traduire, le potentiel des Large Language Models va beaucoup plus loin que ces tâches qualifiées de “simple” en 2024.

Nous allons voir ensemble une application complexe des IA génératives pour résoudre un dilemme vieux comme le monde.

L’expert ou le professeur

Le défi de la pédagogie est la transmission des connaissances depuis l’expert vers l’apprenant (voir notre article sur l'efficacité pédagogique). Cependant, un expert hautement qualifié dans son domaine ne sera pas forcément capable de transmettre efficacement ses connaissances. Car c’est bien là l’enjeu du professeur, lui-même expert d’un domaine : la pédagogie

Cependant, il est difficile de demander à l’expert de devenir professeur et au professeur de devenir expert. C’est là qu’intervient l’ingénieur pédagogique, capable de comprendre et d’organiser la connaissance brute d’un expert pour maximiser la transmission des connaissances.

Ingénieur pédagogique à Prompt Engineer

Il est possible de considérer un LLM comme un assistant à qui l’on va donner des instructions pour effectuer des tâches précises. Ainsi, un ingénieur pédagogique pourra donner des instructions à un LLM afin d’extraire et d’organiser la connaissance brute d’un expert.

Ces instructions simplifiées peuvent être des choses comme l’extraction des messages clés depuis un contenu (découpage), la suggestion d’une erreur commune faite par les apprenants (re-formulation) ou la création d’un débat autour d’un concept (mise en situation). Au-delà des instructions pédagogiques, tout un ensemble de techniques sont utilisées pour contrôler le LLM.

Ce nouveau domaine de recherche apparu en même temps que les LLM se nomme le “Prompt Engineering” et en voici quelques exemples.

Chaine de pensée (Chain of Thoughts)

Cette méthode offre des capacités de raisonnement complexes grâce à des étapes de raisonnement intermédiaires.

Il s’agit par exemple dans un premier temps de demander au LLM d’imaginer quel est le profil de l’apprenant en fonction de la formation choisie et des informations extérieures, puis de générer le contenu pédagogique en adéquation avec ce profil. Cette méthode s’explique par la mise en avant du champ lexical du résultat que l’on souhaite obtenir dans la génération. En montrant la voie au LLM, cela renforce les probabilités que les tokens issus de la génération suivent cette voie.

Stimulus émotionnel (Emotional Stimuli)

La qualité de la génération d’un LLM est meilleure lorsque des messages à caractère émotionnel sont inclus dans le prompt.

Par exemple, en indiquant qu’une tâche est très importante et que son succès sera très apprécié, la génération sera de meilleure qualité.

Appât de génération (Generation Bait)

Il est très difficile de demander à un LLM de ne pas faire quelque chose. En effet, si l’on indique explicitement que l’on ne souhaite pas que quelque chose apparaisse dans la génération, alors cela va renforcer le champ lexical de cette chose et lui donner plus de probabilité d’apparaitre dans la génération. Pour contrer cela, le Prompt Engineer va demander au LLM de générer cette chose à part pour pouvoir ensuite la retirer manuellement de la réponse finale.

Typiquement, si l’on veut être sûr que le LLM ne donne pas d’indices à une question, alors on peut lui demander de commencer par écrire tous les indices possibles dans une question, puis une autre question ne contenant aucun indice.

Ceux qui murmurent aux oreilles des LLMs

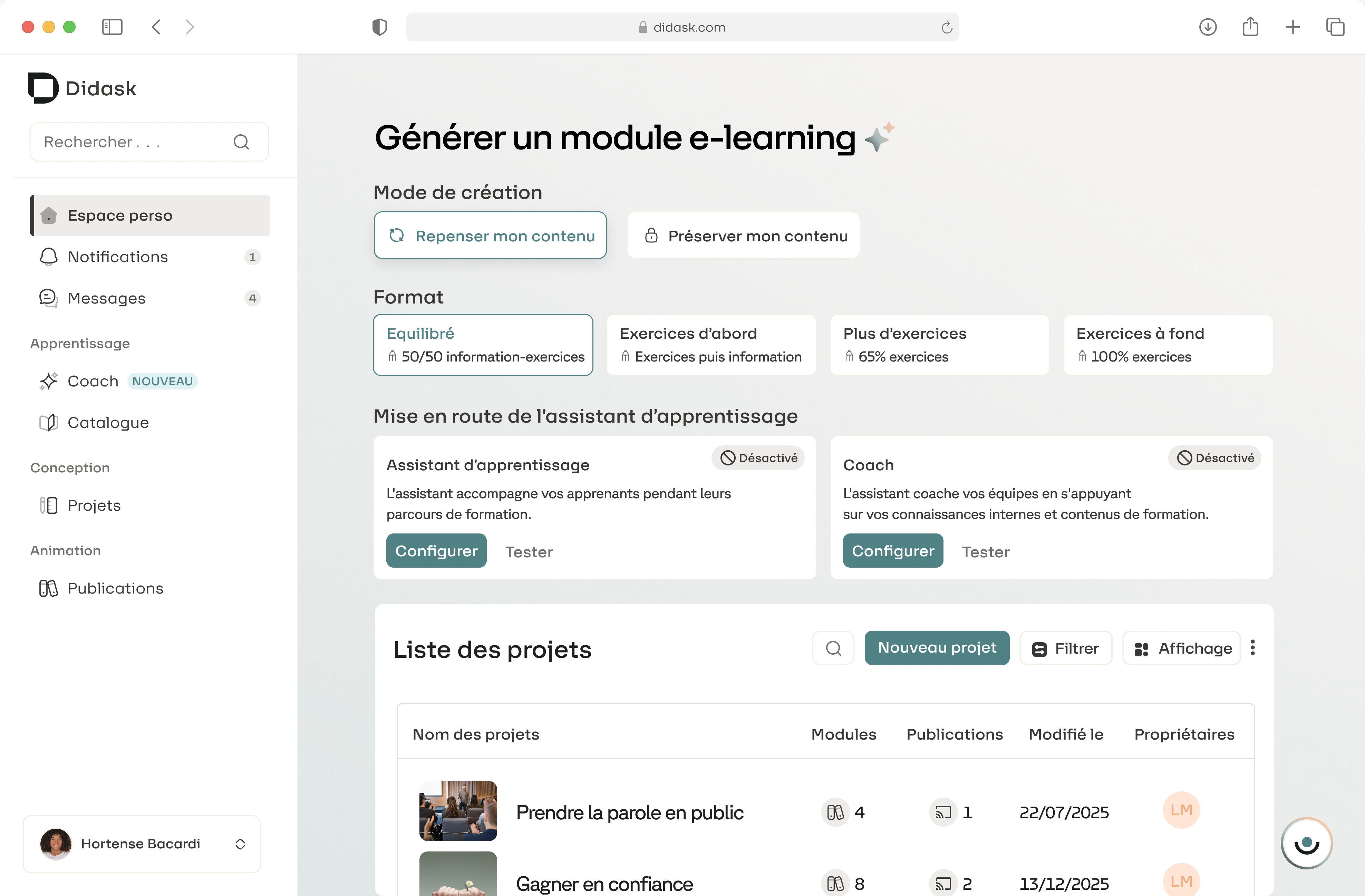

Armé de ses connaissances pédagogiques et de ses compétences de Prompt Engineer, l’ingénieur pédagogique est capable de créer une “copie” de ses processus de travail et de les automatiser. Sur notre marché, nous sommes les premiers à avoir fait ce pari. Notre IA Pédagogique est composée aujourd’hui de plus de 30 jeux d’instructions en cascade (prompts) en fonctions des différents objectifs pédagogiques.

L’IA Pédagogique Didask a déjà aidé des centaines d’entreprises à créer plus de 3000 heures de formation à destination de leurs employés. Ce contenu assisté par IA a pu être créé en moyenne 5 fois plus vite que lors de la création d’une formation e-learning classique.

Et demain ?

La course aux LLMs est lancée et l’arrivée de concurrents sérieux à GPT4 stimule la recherche scientifique et son application dans l’industrie. Aujourd’hui, les modèles Claude 3 (Anthropic), Mistral Large Mistral AI) ou Gemini Ultra (Google) offrent déjà des capacités comparables à GPT4. La prochaine génération de LLMs qui s’ouvrira avec la sortie de GPT5 devrait de pousser encore plus loin la capacité de raisonnement des LLMs et d’en faire de véritables Agents semi-autonome capables d’organiser une série de tâches pour répondre à la problématique qui leur est donnée.

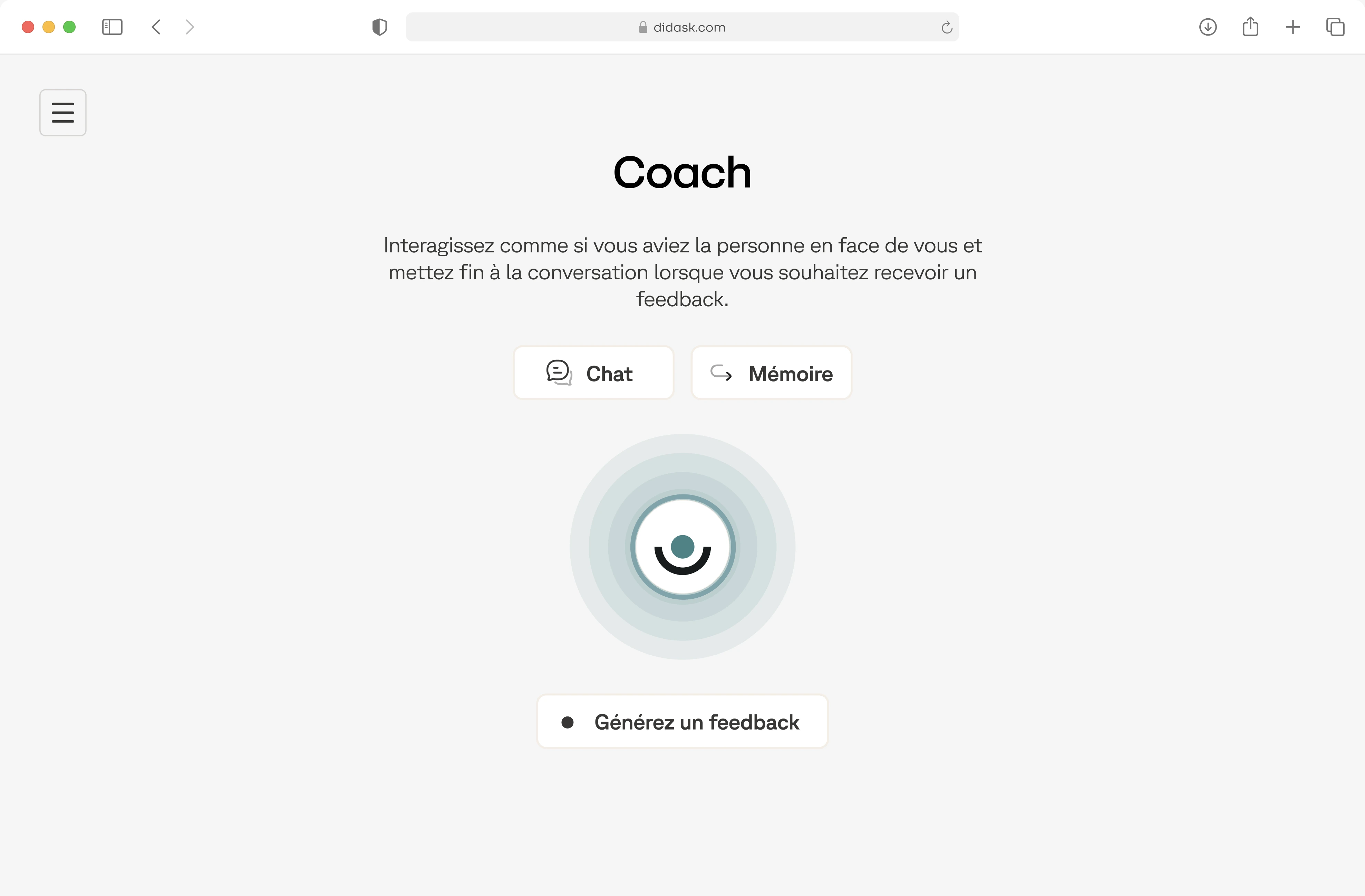

Le e-learning n’est qu’une étape pour Didask dans notre mission d’amélioration des compétences et de la productivité de chacun. Les LLMs ouvrent des portes pour aller encore plus loin et notamment de s’aventurer sur le terrain de l’Adaptive Learning personnalisé avec demain un coach IA pour chacun. Si vois souhaitez d'ailleurs explorer les dernières tendances du e-learning, je vous conseille nos articles "Intelligence artificielle et personnalisation : les tendances e-learning qui vont compter pour les pros" et "Adaptive learning et IA Générative : l’association gagnante pour la formation en ligne !".

Sources pour aller plus loin : Wei et al. 2022, Li et al. 2023

.webp)

.png)